日前,全球人工智能领域顶级国际学术会议AAAI 2026录用结果正式公布。由我校理工学院师生团队所著的两篇论文双双入选会议!该团队成员包括数学系王晋坪、计算机系张丁根两名同学以及计算机系教授高志强、助理学术事务副校长谢志武。其中,本科生王晋坪同学在两篇论文中担任第一作者,高志强教授担任通讯作者。

国际人工智能促进协会年会(AAAI:Association for the Advancement of Artificial Intelligence),是全球人工智能领域“三大顶级学术会议”之一,同时也是中国计算机学会(China Computer Federation,CCF)推荐列表中的A类会议,h5-median高达358,h5-index高达232。本届AAAI投稿最终录用率仅17.6%。

值得一提的是,《Escaping Optimization Stagnation: Taking Steps Beyond Task Arithmetic via Difference Vectors(差分向量,让模型摆脱“卡壳”)》一文还获得了oral presentation(口头报告)的展示机会,约占所有投稿比例中的2.5%。据了解,仅有在原创性、学术影响力、技术突破性与行业引领性等方面达到国际前沿的成果才能入选展示。这些科研成果对本科阶段的同学而言尤为难得,也是我校在人工智能基础研究和应用探索方面的新突破。

师生合作科研

两篇论文的背后,是整个团队踏实而持久的投入。从研究方向的确立、跨学科资源的协调,到实验方案设计、设备与算力统筹,再到长期的实验调试和多轮论文写作修改,每一个环节都依赖反复讨论和打磨。

顶会投稿节奏紧张,为了按时、优质地完成投稿任务,王晋坪同学也经历了多次“通宵连轴转”,在实践中逐渐学会如何在高标准要求下推进复杂的科研工程。他分享说:“我学会了如何从混乱的现象里整理出清晰的逻辑。任何一次看似失败的实验,其实都在提醒我思考得还不够深,坚持下去往往能迎来关键性的突破。”

高志强教授也分享,要高质量地完成一个科研项目,远远不止“会写代码”这么简单。学生既要具备自学与自由探索的能力,也要能在课程压力和科研进度之间做好时间规划,还需要学会与导师和组内同学进行高效沟通。

同在科研小组的张丁根表示:“无论是学校内能随时使用的算力资源、开放的实验环境,还是导师们给予的许多启发性的建议,都让我们这些学生能真正站到科研一线去尝试、去探索。科研不再遥不可及。”

2025年SSpF项目汇报

据悉,此次入选AAAI 2026的成果始于2025年度夏季师生拍档科研项目(Summer Student Partnering with Faculty Research Program,SSpF),并在SSpF项目评选中荣获优秀奖。自2015年启动以来,师生拍档科研项目已成为温州肯恩大学科研育人的重要平台。截至2025年6月,已有超过560名学生和140名教师参与师生拍档科研项目,立项290余项,资助总额近750万元,学生以第一作者或通讯作者身份在SCI、SSCI等国际期刊发表论文超过310篇,多项成果入选国内外学术会议并进行汇报。

下面,让我们一同看看入选会议的2篇成果都有哪些前沿思路吧!

在具体研究内容上,这两篇论文都围绕机器学习的核心算法展开,目标是在复杂真实场景中,让模型更加鲁棒、可靠和值得信任。

差分向量,让模型摆脱“卡壳”

《Escaping Optimization Stagnation: Taking Steps Beyond Task Arithmetic via Difference Vectors》论文简介

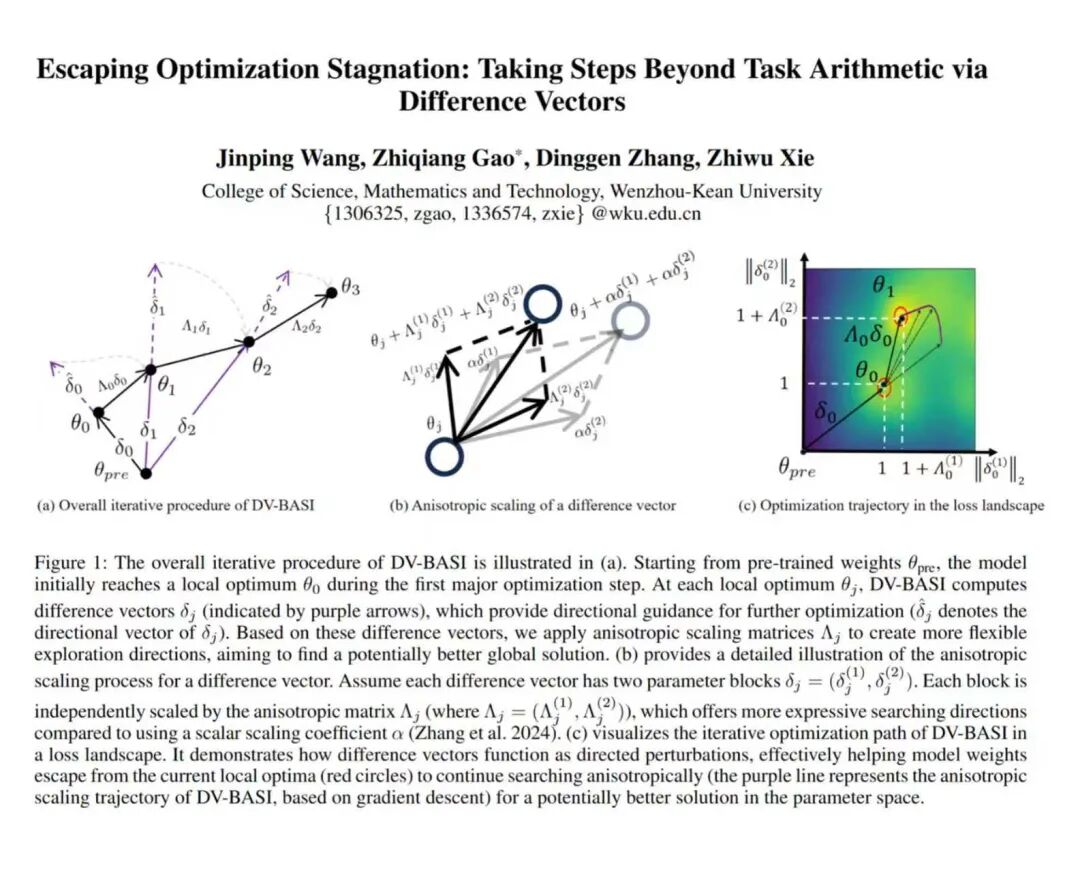

该篇论文获得oral presentation,聚焦于当前备受关注的“模型编辑(Model Editing)”问题:一个已经预训练好的大模型,如何在不推倒重来的前提下顺利学会新任务、修正旧行为,而不是学到一半就“卡在原地”。现有常见方法往往基于“任务算术(Task Arithmetic)”,先针对不同任务分别微调同一个模型,再通过简单的“加减法”组合这些任务向量,如果模型在某个状态陷入优化停滞,就很难继续提升。

为此,论文提出了差分向量块级各向异性缩放迭代方法DV-BASI (Difference Vector Block-wise Anisotropic Scaling and Iteration)。简单来说,它不再只看某一次微调前后的差异,而是把训练过程中的整段“学习轨迹”提炼成差分向量,并对不同参数块进行有方向、有力度的多步更新,好比给模型加上一股“会思考的推力”,在遇到局部最优时把它从原地推开,引导继续向前。实验结果表明,在多任务组合、任务否定以及测试时自适应等典型场景中,DV-BASI 能在不增加额外网络结构的前提下,稳步提升整体表现,让模型在不断学习新能力的同时,更好地保留和兼顾原有能力。

空间对齐,让“多数类”和“少数类”都被看见

《Space Alignment Matters: The Missing Piece for Inducing Neural Collapse in Long-Tailed Learning》论文简介

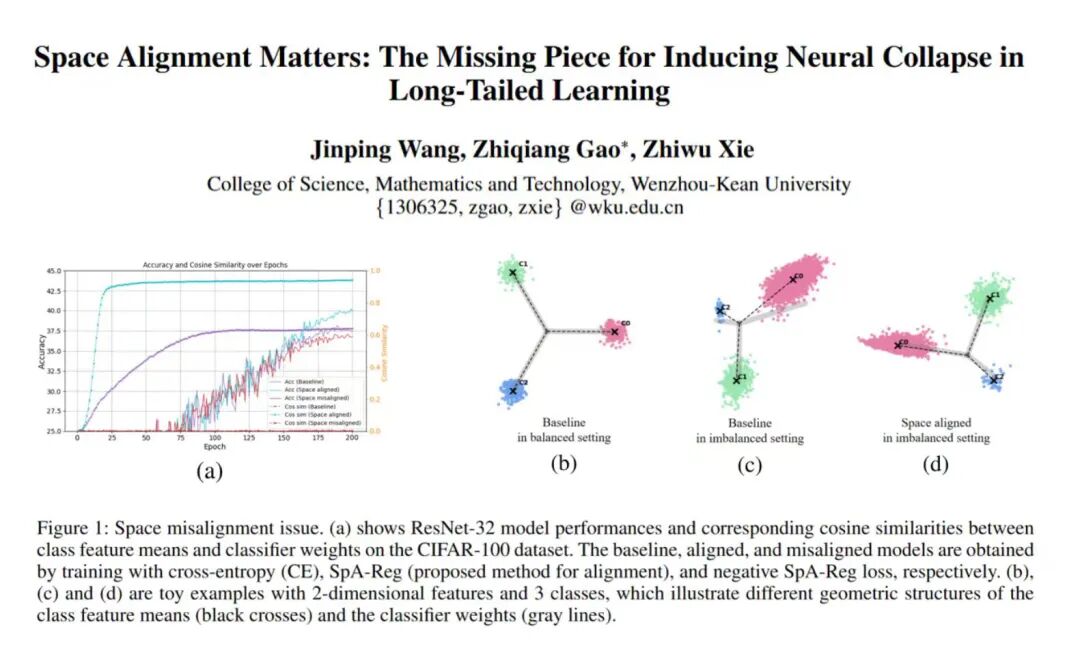

该论文面向现实应用中非常常见的“长尾分布(Long-tailed Distribution)”问题,即有的类别数据成千上万,有的类别样本却寥寥无几,这类任务统称为长尾学习(Long-tailed Learning)。在这种不均衡的数据下,传统模型往往更偏向样本多的“多数类”,样本少的“少数类”容易被误判甚至忽略。理论研究中的“神经坍塌(Neural Collapse)”现象指出,在理想情况下,特征和分类器会形成一种几何结构很整齐的状态,有利于分类稳定和泛化;但在长尾场景下,尤其是少数类,这种结构会被严重破坏。

论文从“空间对齐(Space Alignment)”的视角切入,同时关注特征空间和分类器空间是否真正对得上:一方面在理论上分析了两者方向不一致时对误差指数(Optimal Error Exponent)的影响,说明这种错位会拖累整体性能;另一方面设计了一组轻量的方法,在不改变网络架构的前提下,通过正则、插值和投影等方式,把特征方向和分类器方向逐步“拧回到一条线上”。从技术角度看,这使得模型在长尾数据集上更接近期望中的几何结构;从直观效果看,就是让模型在多数类和少数类之间做出更平衡的判断,在多个标准数据集上显著提升了少数类识别表现,使整体系统更稳健、更可信。

▼推 / 荐 / 阅 / 读

图文 | 受访者提供

文稿编辑 | 项温蔚

一审 | 侯倩雅

二审 | 王舒

三审 | 吕卓环

责编 | 传播与公共关系部